O mundo da tecnologia enfrenta uma escassez crítica de chips de memória e, embora as empresas na CES estejam ansiosas por apresentar inovações, a realidade é muito mais premente: uma grave escassez de DRAM (memória dinâmica de acesso aleatório) ameaça a disponibilidade e acessibilidade futura dos produtos. Este não é um problema apenas para construtores de PC hardcore; laptops e telefones também estão em risco, pois os fabricantes priorizam os data centers de IA em vez dos dispositivos de consumo.

Várias empresas estão a tomar medidas ousadas para mitigar a crise, embora o sucesso não seja garantido. Esses esforços dependem de mudanças de estratégias, redução da dependência da IA baseada em nuvem e convencimento do mercado de memória a reinvestir na produção de DRAM para o consumidor.

O dreno da demanda de IA

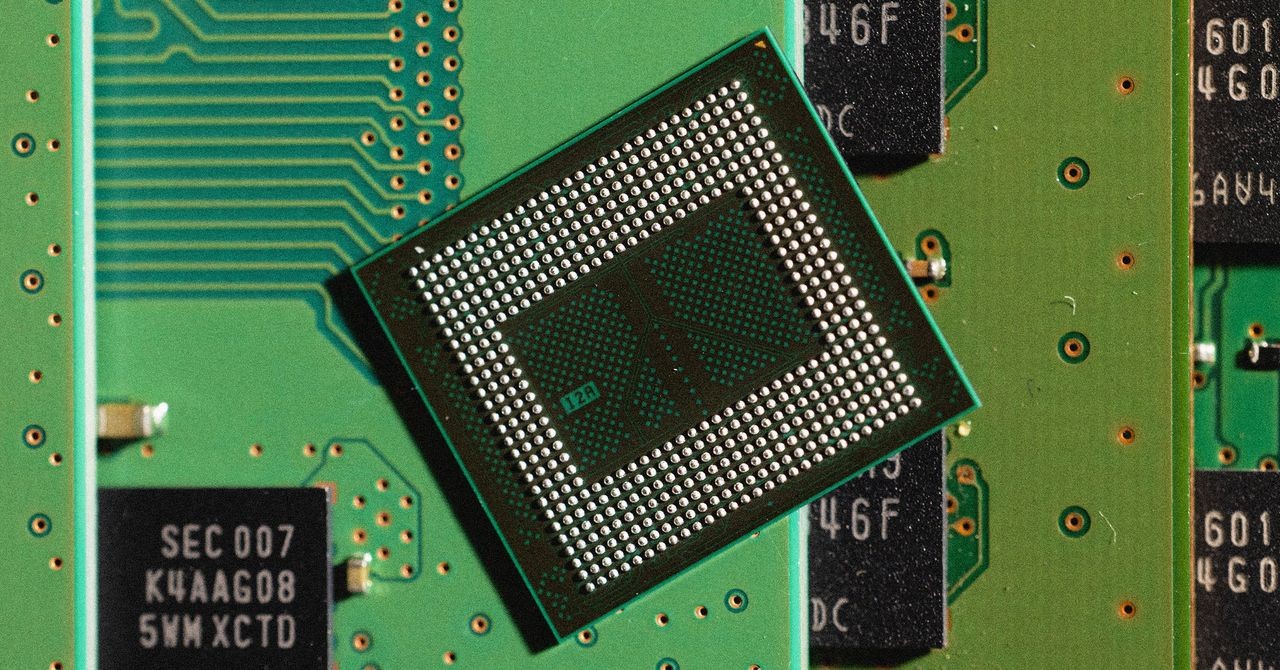

A escassez atual não é aleatória. O aumento na demanda por memória de alta largura de banda (HBM) para data centers de IA levou os principais fabricantes a despriorizarem a produção de DRAM – o tipo de memória usada em laptops e smartphones do dia a dia. Este desequilíbrio força os consumidores a confiarem em serviços de IA baseados na nuvem, como o ChatGPT, porque os seus dispositivos não têm a memória necessária para executar estes modelos localmente.

O COO da Dell, Jeff Clarke, reconheceu a gravidade da situação, afirmando que as condições atuais são “a pior escassez que já vi”. Os preços já subiram, com a DRAM aumentando 40% no final de 2025 e projetando-se que aumente mais 60% no início de 2026. Grandes fabricantes como Asus e Dell anunciaram aumentos de preços e ajustes de configuração para lidar com a escassez.

Soluções inovadoras: IA no dispositivo e redesenho térmico

Apesar das perspectivas sombrias, duas empresas estão a tentar perturbar o status quo. Phison, um fabricante taiwanês de controladores, desenvolveu o aiDAPTIV, um cache SSD que pode efetivamente expandir a largura de banda da memória para tarefas de IA. Isso permite que os fabricantes reduzam a capacidade DRAM em laptops (por exemplo, de 32 GB para 16 GB) sem impactar significativamente o desempenho, aliviando potencialmente a tensão no fornecimento. O suporte inicial da MSI e da Intel sugere que uma implementação rápida pode ser possível.

A Ventiva, por sua vez, está abordando a questão do ponto de vista térmico. Seu sistema de resfriamento sem ventoinha remove componentes de resfriamento volumosos, criando espaço para módulos DRAM adicionais em laptops. O CEO Carl Schlachte argumenta que otimizar o espaço físico para memória é uma solução importante negligenciada. A ideia é tornar o processamento de IA no dispositivo tão atraente para consumidores e empresas que impulsione a procura por DRAM, incentivando os fabricantes a reinvestir na sua produção.

A aposta de longo prazo

O sucesso dessas estratégias depende de um esforço coletivo dos fabricantes de notebooks, Intel, AMD e produtores de memória. Convencê-los a priorizar a IA no dispositivo e voltar o foco para DRAM requer uma mensagem e uma demanda de mercado unificadas. Se estes esforços falharem, as consequências serão terríveis: preços inflacionados, desempenho reduzido e dependência contínua de serviços dispendiosos em nuvem.

Como disse Schlachte: “Gastamos o dinheiro da herança no data center… e eles vão alugá-lo de volta para você”. A indústria tecnológica está numa encruzilhada: ou redirecciona recursos para capacitar os consumidores com capacidades locais de IA ou entrega o controlo a um punhado de empresas dominantes na nuvem. O resultado determinará o futuro da computação nos próximos anos.